El creciente consumo energético de la inteligencia artificial (IA) y los desafíos en su cadena de suministro son el foco de un reciente análisis publicado en la revista Joule, a cargo de Alex de Vries-Gao. La investigación subraya la opacidad en la información sobre el consumo de energía de la IA y cómo las limitaciones en la fabricación de hardware específico están impactando su expansión y demanda energética global.

La adopción masiva de la IA generativa en 2023 y 2024, impulsada por herramientas como ChatGPT de OpenAI, ha llevado a un rápido aumento en la demanda de energía de los centros de datos.

Empresas tecnológicas como Google han descrito incrementos significativos en su consumo de electricidad y emisiones de carbono, señalando a la IA como el principal motor de este crecimiento.

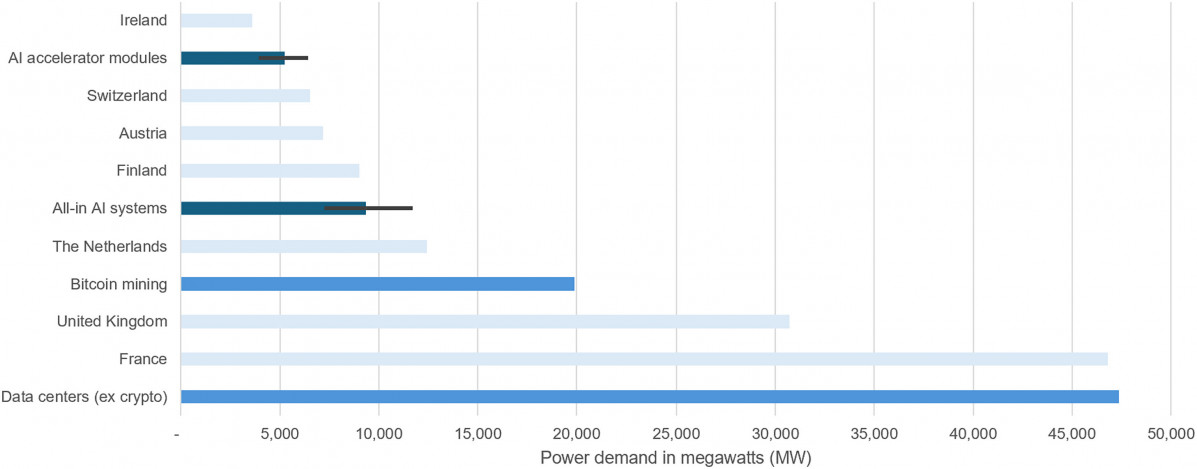

Sin embargo, la falta de datos desagregados por tipo de carga de trabajo hace difícil precisar el consumo real de energía de la IA. La Agencia Internacional de la Energía estimó que todos los centros de datos combinados (excluyendo la minería de criptomonedas) consumieron 415 TWh de electricidad en 2024.

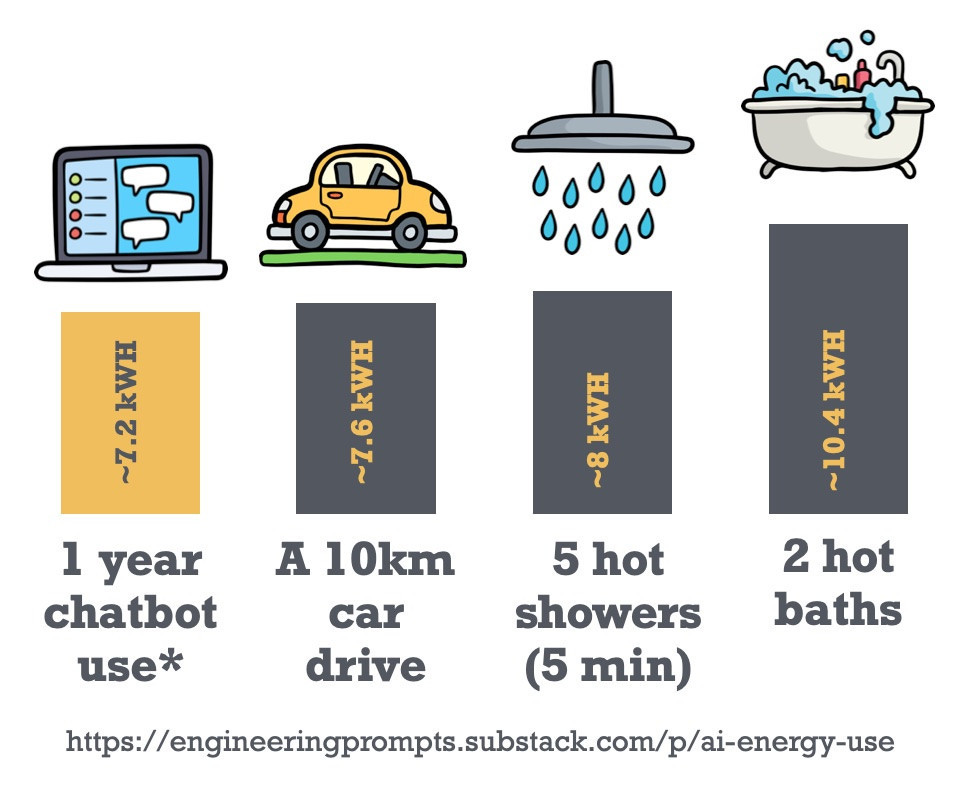

Para dimensionar el uso de energía de la IA, un grupo de ingenieros de la Universidad EPFL (institución suiza de ciencia y tecnología), ha realizado una comparación entre el consumo anual de un chatbot y actividades cotidianas.

Un año de uso regular de un chatbot (estimado en 100 interacciones diarias por persona, cada una con unas 10 idas y venidas de mensajes) consumiría alrededor de 7.2 kilovatios-hora (kWh).

Esta cifra, sorprendentemente, es menor que la energía que se gasta en:

Aunque las estimaciones de consumo de IA pueden variar, esta comparación pone en perspectiva que el uso "típico" de un chatbot es menos intensivo en energía que muchas de nuestras actividades diarias. Sin embargo, es crucial destacar que el uso de modelos de IA muy grandes, agentes especializados o la generación de imágenes y vídeo eleva significativamente el consumo energético.

Un factor crucial en la evaluación del consumo energético de la IA es la capacidad de fabricación de hardware especializado.

Existe un consenso sobre la importancia de la capacidad de empaquetado CoWoS (chip-on-wafer-on-substrate) de Taiwan Semiconductor Manufacturing Company (TSMC), un actor clave en la producción de aceleradores de IA.

Esta tecnología es fundamental para integrar unidades de procesamiento como las GPUs y la memoria de alto ancho de banda (HBM) en un solo paquete, lo que es esencial para superar el "muro de la memoria" que limita el rendimiento de las aplicaciones de IA.

Compañías líderes como NVIDIA, AMD y Google utilizan HBM y la tecnología CoWoS para sus avanzados aceleradores de IA, lo que ha convertido la capacidad de CoWoS en el principal cuello de botella para su fabricación.

A lo largo de 2023 y 2024, la demanda de capacidad CoWoS de TSMC superó con creces su oferta. Aunque TSMC ha logrado duplicar su capacidad CoWoS de 2023 a 2024, y planea hacerlo de nuevo en 2025, la escasez persistió, lo que confirma que la capacidad está altamente concentrada en la demanda relacionada con la IA.

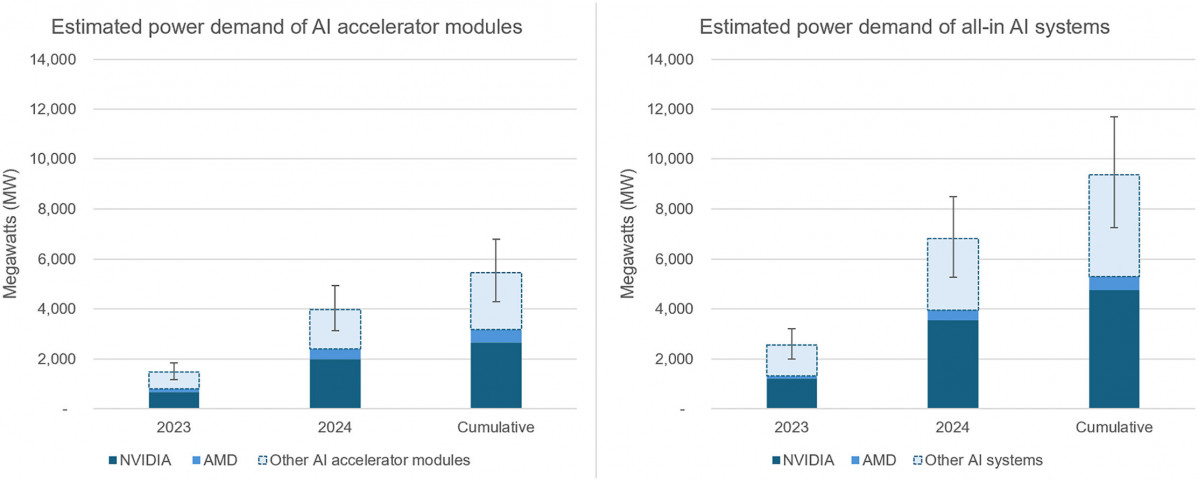

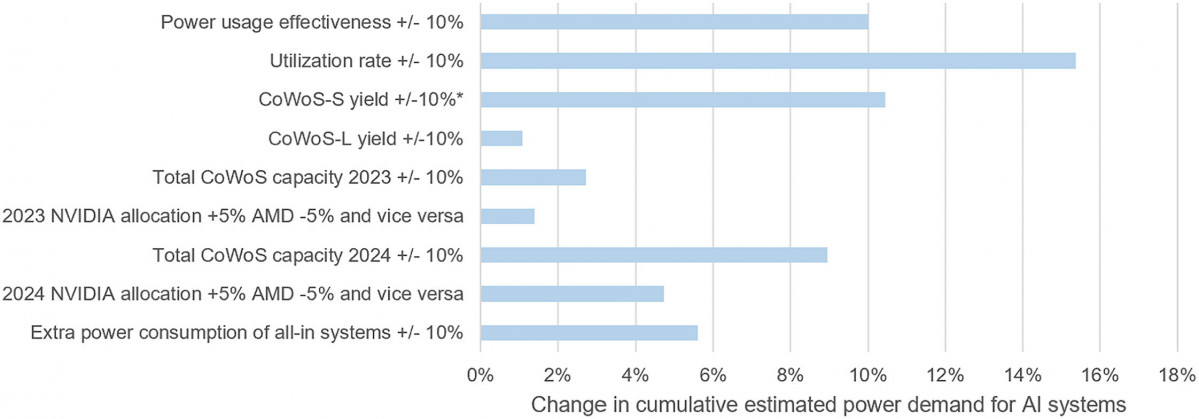

Basándose en las estimaciones de la capacidad CoWoS de TSMC y la producción de dispositivos de NVIDIA y AMD, el análisis de Alex de Vries-Gao proyecta un aumento considerable en la demanda de energía. Se estima que los módulos de aceleradores de IA producidos por NVIDIA y AMD en 2023 y 2024 podrían alcanzar una demanda de energía acumulada de 3.0 GW para 2025.

Si se incluyen otros módulos de aceleradores de IA que utilizan la capacidad CoWoS de TSMC, esta cifra podría ascender a 5.2 GW.

Considerando los sistemas completos de IA, que incluyen componentes adicionales además de los aceleradores, la demanda de energía podría aumentar a 5.3 GW para NVIDIA y AMD, y hasta 9.4 GW si se consideran otros sistemas de IA.

Con una tasa de utilización del 65 por ciento y una efectividad de uso de energía (PUE) de 1.2 en los centros de datos, esto podría traducirse en un consumo anual de electricidad de 46 a 82 TWh (teravatios-hora) para 2025. Esta cifra es comparable al consumo anual de electricidad de países como Suiza, Austria o Finlandia.

De hecho, los aceleradores de IA especializados podrían representar entre el 11 por ciento y el 20 por ciento del consumo total de electricidad de los centros de datos a nivel global (excluyendo la minería de criptomonedas).

La proyección de que la capacidad CoWoS de TSMC se duplique nuevamente en 2025 sugiere que la demanda de energía asociada con los dispositivos de IA podría seguir una tendencia similar.

Esto podría llevar la demanda acumulada de los módulos de aceleradores de IA producidos entre 2023 y 2025 a 12.8 GW, y hasta 23 GW para los sistemas de IA completos para finales de 2025. Esta última cifra superaría el consumo de electricidad de la minería de Bitcoin y se acercaría a la mitad del consumo total de electricidad de los centros de datos (excluyendo criptomonedas) en 2024.

Sin embargo, el informe también señala factores que podrían mitigar este crecimiento, como los problemas de rendimiento en la nueva tecnología de empaquetado CoWoS-L y una posible disminución en el entusiasmo por las aplicaciones de IA. Además, las tensiones geopolíticas y los controles a la exportación podrían introducir nuevas interrupciones en la cadena de suministro de hardware de IA.

La necesidad de transparencia en los datos de consumo energético de la IA es urgente para una planificación eficaz de la infraestructura energética y el desarrollo de políticas de sostenibilidad. La inversión masiva en nueva infraestructura de centros de datos para IA, como la iniciativa Stargate de OpenAI en EEUU, plantea preocupaciones sobre una posible mayor dependencia de los combustibles fósiles.

Los investigadores instan a una mayor divulgación de datos para evaluar mejor las implicaciones ambientales y los costos asociados al desarrollo y despliegue de la inteligencia artificial.

La demanda energética de la IA y los desafíos en la cadena de suministro de hardware no son una preocupación exclusiva de las grandes potencias tecnológicas; España también se enfrenta a este escenario, con proyecciones que sitúan al país en una posición relevante en el mapa del consumo energético de la IA.

Desde la Cátedra Inditex-UDC de IA en Algoritmos Verdes de la Universidade da Coruña (UDC), que dirige la doctora en informática Verónica Bolón Canedo, se aborda el desafío del consumo energético de la IA mediante la investigación y desarrollo de algoritmos más eficientes y sostenibles.

Verónica Bolón Canedo explica que su enfoque incluye la optimización del rendimiento de los modelos de IA, incluidos los de lenguaje, para reducir su huella energética. Además, aplican algoritmos de IA a problemas de sostenibilidad como la eficiencia energética en edificios y promueven la investigación en robótica sostenible.

Desde su perspectiva, el aumento del consumo energético de la IA no se debe solo a la expansión de los centros de datos, sino también a la creciente complejidad de los modelos, la necesidad de procesar grandes volúmenes de datos y el intenso uso al que están siendo sometidos.

Subraya que, aunque el hardware es importante, la eficiencia del software y los algoritmos aún no reciben la atención que merecen y que es crucial invertir en "algoritmos verdes" que prioricen la eficiencia energética.

Para una mayor transparencia y medición precisa de la huella de la IA, la directora de la cátedra sugiere implementar etiquetas de consumo energético, similares a las de los electrodomésticos, que permitan conocer el impacto de los modelos de IA de forma clara y accesible. También considera necesario establecer estándares y marcos internacionales que obliguen a las empresas a informar de este consumo de manera transparente.

La "IA verde" o "algoritmos verdes" se materializan en la cátedra con dos enfoques principales: "green-in", con el desarrollo de algoritmos eficientes que minimizan el consumo de energía desde el diseño, y "green-by", que utiliza la IA para optimizar otros sistemas como la gestión energética o la producción sostenible.

A corto y medio plazo, el equipo liderado por Verónica Bolón busca avanzar en algoritmos más ligeros y sostenibles, aplicando técnicas como el aprendizaje federado, y colaborar con la industria para implementar estos avances y promover la eficiencia energética en operaciones y cadenas de suministro.

La colaboración con Inditex permite que los investigadores de la UDC desarrollen sus investigaciones sobre algoritmos verdes, colaborando en líneas orientadas a la eficiencia energética y la sostenibilidad en la IA, además de en programas de formación.

Por otro lado, y más allá del consumo energético, la cátedra aborda implicaciones ambientales más amplias en su línea de investigación sobre la transcendencia legal, social y económica de los algoritmos verdes, analizando cómo la IA sostenible afecta a estos ámbitos y cómo mitigar efectos negativos, incluyendo la percepción ciudadana de estos problemas.

En el caso específico de Galicia, Verónica Bolón Canedo destaca que la Universidade da Coruña lleva varios años trabajando en algoritmos verdes y que la Cátedra de IA en Algoritmos Verdes es la única cátedra ENIA (Estrategia Nacional de Inteligencia Artificial) financiada específicamente para este asunto, lo que demuestra un firme compromiso con la IA sostenible.

Galicia, con infraestructuras como el CESGA (Centro de Supercomputación de Galicia), tiene un gran potencial para ser un referente en IA verde. El CESGA, como centro de supercomputación, facilita el acceso a recursos computacionales avanzados y sostenibles, lo que permite investigaciones en IA más eficientes y con menor impacto ambiental.

Las universidades y la investigación son clave en la formación de profesionales y la transferencia de conocimiento para una IA más sostenible en España. Sin embargo, la Dra. Bolón Canedo advierte de que actualmente no existen suficientes profesionales especializados en IA verde, y señala que la formación en este ámbito aún incipiente.

Para cubrir esta brecha, la cátedra ha desarrollado un programa de formación amplio, incluyendo un curso experto y microcredenciales que permiten formar profesionales cualificados en algoritmos verdes e IA sostenible.

En los próximos 5 o 10 años, tendencias emergentes como los modelos más eficientes (mixture of experts), la destilación de modelos, el uso de representaciones de datos más eficientes y el desarrollo de chips especializados más eficientes tendrán un impacto relevante en la huella energética de la IA. El avance de centros de datos optimizados para el uso de energía renovable también será clave.

Para fomentar una IA más sostenible, la Dra. Bolón considera que las políticas públicas deben centrarse en promover tecnologías que minimicen el impacto ambiental y fomentar la colaboración entre los sectores público, privado y académico.

La Estrategia de Inteligencia Artificial 2024 de España establece un marco para la sostenibilidad, pero podría beneficiarse de una mayor inclusión de criterios ambientales en la evaluación de los sistemas de IA.

La ley europea (AI Act) también establece obligaciones para evaluar el impacto ambiental, aunque hay áreas mejorables como la evaluación del consumo energético durante la inferencia y las emisiones indirectas. En general, es necesario seguir fortaleciendo los marcos regulatorios y promover la colaboración para lograr una IA más sostenible.

El auge de la IA y los centros de datos presenta una oportunidad de crecimiento, pero también un desafío significativo en términos de demanda eléctrica y sostenibilidad. La clave estará en cómo cada país logre equilibrar el desarrollo tecnológico con una sólida estrategia de energías renovables y eficiencia para asegurar un futuro digital sostenible.